- Investment

- 科学论坛

-

Program

- Recruitment

- Center

News Message

基于深度强化学习的遥感视频目标跟踪

- by wittx 2022-03-19

No.1

背景与动机

目标跟踪是在连续的视频序列中,建立所要跟踪物体的位置关系,得到物体完整的运动轨迹。给定图像第一帧的目标坐标位置,计算在下一帧图像中目标的确切位置。它是遥感领域空间对地观测的一个重要研究方向,在军事监测、战场分析、武器导航、导弹预警系统、交通管理和公共安全等方面有着广泛的应用。近年来,已有的目标跟踪算法取得了很大的成功。然而,由于被跟踪物体的多样性和外部环境的复杂性,目标跟踪一直是一项具有挑战性的任务。一个鲁棒的目标跟踪算法必须能够解决跟踪过程中遇到的各种困难,如外观变形、光照变化、快速运动和运动模糊、背景相似干扰、平面外旋转、平面内旋转、尺度变化、出视野和遮挡。

解决遮挡问题是目标跟踪中重要且具挑战性的研究方向之一。近年来,国内外学者已对该领域进行了研究。然而,仍有一些问题需要解决。首先,之前的研究侧重于自然图像,而不是遥感图像。与自然图像相比,遥感图像中目标所占比例较小,背景相似干扰较多,空间分辨率较低。因此,从遥感图像中提取特征变得更加困难。其次,大多数跟踪方法均采用复杂的网络模型来解决遮挡问题,需对被遮挡的目标进行重新检测,非常耗时。另外,当目标被大面积遮挡甚至完全遮挡时,被跟踪目标的位置出现不准确或丢失。

为了解决遥感视频中单目标跟踪的完全遮挡问题,我们采用深度强化学习框架对完全遮挡下的遥感目标跟踪进行建模。该算法结合了时空背景、物体外观模型和运动矢量提供的目标遮挡信息,显著提高了跟踪算法的鲁棒性。

No.2

方法介绍

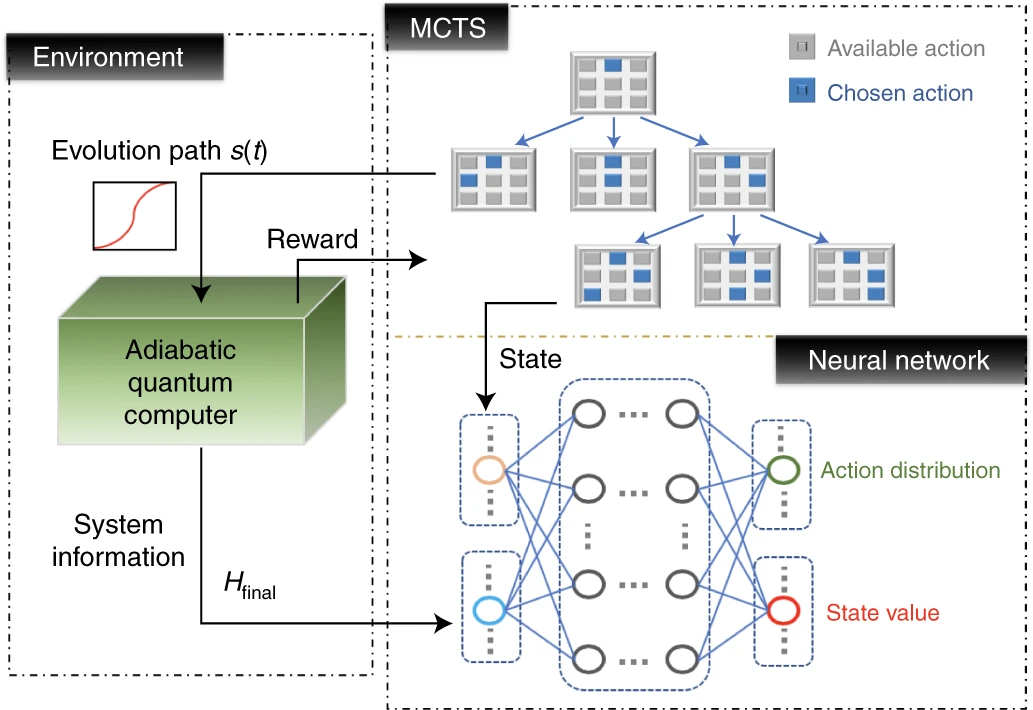

目标跟踪问题可以描述为一个马尔可夫决策过程(MDP),包含一组动作A 、一组状态S、状态转移矩阵P和奖励函数R。将跟踪器视为一个智能体,其目标是获取被跟踪物体的确切位置。跟踪器可以通过迭代获得遥感视频中每一帧的状态和动作。

图1 动作类型

1)动作:共有三种类型:平移、尺度变化、停止(图1)。平移包含八个方向,即左、右、上、下、左上、右上、左下和右下。尺度变化包括放大和缩小。停止发生在没有更多动作时,同时在当前帧收到奖励。

2)状态:状态由物体的外观模型和动作动力学两部分组成。物体的外观模型是针对边界框内的图像块,它是从视频帧的原始图像中裁剪出来的。在边界框中有左上角的坐标位置、宽度和高度的信息。动作动力学连接了之前的动作信息。

3)状态转移矩阵:跟踪器在当前状态处采取决策动作后,通过状态转移获得下一个状态,同时根据相应的动作移动边界框。

4)奖励:奖励反映跟踪器是否成功跟踪到目标。IoU表示跟踪的边界框与真实值的重叠率。当选择停止动作时,我们将奖励函数定义为

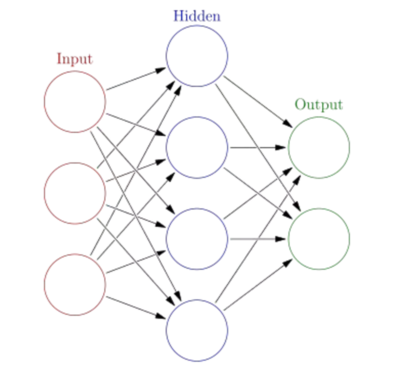

所提出的AD-OHNet网络架构如图 2 所示。

图2 网络架构

利用随机梯度下降法最小化损失函数,对网络参数进行训练。损失函数定义为

当置信度小于0.5时,则判定跟踪失败,跟踪算法进行遮挡处理。采用时空背景、物体外观模型和运动矢量驱动强化学习的动作。首先,通过对完全遮挡之前的动作和状态的统计,为当前帧提供时间和空间信息。需计算物体在每一帧中的平均移动方向和距离。其次,在物体边界框周围IoU >0.7区域随机选取k个样本作为正样本,同时在IoU < 0.3区域随机选取k个样本作为负样本。在完全遮挡的情况下,正样本和负样本保持不变。另外,需要保存之前的动作动力学矢量,以便在完全遮挡下进行目标跟踪。通过存储之前的运动矢量,跟踪器可以在后续帧中做出正确的动作,而不是在遮挡下盲目地进行搜索。根据目标的原始运动轨迹,包括运动方向和速度,保存之前的动作,使跟踪在完全遮挡情况下沿原始方向进行。利用上下文信息,获得当前帧目标的运动方向。

No.3

实验分析

我们采用中国第一颗商用遥感卫星吉林一号卫星的波哥大、香港和圣地亚哥的遥感视频序列。波哥大、香港和圣地亚哥的分辨率分别为0.92米、0.98米和1.16米。在这些视频序列中有不同的目标类型,包括飞机、汽车、船、机场、港口和军舰。波哥大、香港和圣地亚哥的原始视频的对地实际尺寸分别为55.2平方公里、58.8平方公里和69.6平方公里。每秒10帧,视频时长为33秒,每帧图像大小为12000 × 5000像素。由于原始图像尺寸过大无法提取特征,因此在视频中找到感兴趣的区域,并手动标注ground truth信息来实现目标跟踪。此外,还有一些具有挑战性的情况,如曲线行驶的目标、小目标、转弯时完全遮挡、同一视频序列中出现两次完全遮挡,以及目标被云遮挡。每个测试的视频序列有100 ~ 330帧,其中被遮挡的帧数为10 ~ 33帧不等。采用该遥感视频序列,实验验证了所提出的AD-OHNet跟踪算法的有效性。

我们将所提出的AD-OHNet方法与九个先进的跟踪算法进行了比较。图3所示为precision plots 和 success plots。对比结果表明,所提出的AD-OHNet与现有的跟踪算法相比实现了卓越的性能。在遇到完全遮挡的视频序列后,大多数跟踪器将无法准确定位目标。而在AD-OHNet跟踪算法中,当阈值为20px时,精度可达92.6%。从图3可以看出,AD-OHNet方法可以有效地解决遥感视频序列的遮挡问题。

图3 precision plots 和 success plots

图4是AD-OHNet与其他五种跟踪算法进行定性比较的实验结果。其中包含了一些具有挑战性的情况,如曲线行驶的目标,小目标,甚至目标在转弯过程中被完全遮挡。

图4 实验结果

我们评估了AD-OHNet对初始化的鲁棒性。除了OPE之外,还有两种鲁棒性度量初始化评估方法:空间鲁棒性评估(SRE)和时间鲁棒性评估(TRE)。SRE通过对起始帧的目标位置信息进行移动或缩放,形成若干段测试序列进行测试和评估。TRE是从整个序列中截取若干段,即从不同时刻作为起始帧,从而实现目标跟踪。图3结果表明,该方法具有较好的鲁棒性。

No.4

总结与展望

在本文中,我们提出了一种基于深度强化学习的目标跟踪方法来解决遥感视频中目标完全遮挡的问题。该算法即使在一些稍复杂的情况下也能实现良好的跟踪性能。本文采用时空上下文、物体外观模型和运动矢量驱动遮挡下的强化学习动作。实验结果证明了该跟踪算法的有效性。然而,本研究仍不能解决某些复杂场景中的目标遮挡问题。例如,由于跟踪镜头或云的移动而导致物体被遮挡。在这种情况下,卫星和目标同时运动,目标的运动方向和速度会在遮挡过程中发生变化。未来可采用更复杂的网络模型以实现该场景下的目标跟踪。

No.1

背景与动机

目标跟踪是在连续的视频序列中,建立所要跟踪物体的位置关系,得到物体完整的运动轨迹。给定图像第一帧的目标坐标位置,计算在下一帧图像中目标的确切位置。它是遥感领域空间对地观测的一个重要研究方向,在军事监测、战场分析、武器导航、导弹预警系统、交通管理和公共安全等方面有着广泛的应用。近年来,已有的目标跟踪算法取得了很大的成功。然而,由于被跟踪物体的多样性和外部环境的复杂性,目标跟踪一直是一项具有挑战性的任务。一个鲁棒的目标跟踪算法必须能够解决跟踪过程中遇到的各种困难,如外观变形、光照变化、快速运动和运动模糊、背景相似干扰、平面外旋转、平面内旋转、尺度变化、出视野和遮挡。

解决遮挡问题是目标跟踪中重要且具挑战性的研究方向之一。近年来,国内外学者已对该领域进行了研究。然而,仍有一些问题需要解决。首先,之前的研究侧重于自然图像,而不是遥感图像。与自然图像相比,遥感图像中目标所占比例较小,背景相似干扰较多,空间分辨率较低。因此,从遥感图像中提取特征变得更加困难。其次,大多数跟踪方法均采用复杂的网络模型来解决遮挡问题,需对被遮挡的目标进行重新检测,非常耗时。另外,当目标被大面积遮挡甚至完全遮挡时,被跟踪目标的位置出现不准确或丢失。

为了解决遥感视频中单目标跟踪的完全遮挡问题,我们采用深度强化学习框架对完全遮挡下的遥感目标跟踪进行建模。该算法结合了时空背景、物体外观模型和运动矢量提供的目标遮挡信息,显著提高了跟踪算法的鲁棒性。

No.2

方法介绍

目标跟踪问题可以描述为一个马尔可夫决策过程(MDP),包含一组动作A 、一组状态S、状态转移矩阵P和奖励函数R。将跟踪器视为一个智能体,其目标是获取被跟踪物体的确切位置。跟踪器可以通过迭代获得遥感视频中每一帧的状态和动作。

图1 动作类型

1)动作:共有三种类型:平移、尺度变化、停止(图1)。平移包含八个方向,即左、右、上、下、左上、右上、左下和右下。尺度变化包括放大和缩小。停止发生在没有更多动作时,同时在当前帧收到奖励。

2)状态:状态由物体的外观模型和动作动力学两部分组成。物体的外观模型是针对边界框内的图像块,它是从视频帧的原始图像中裁剪出来的。在边界框中有左上角的坐标位置、宽度和高度的信息。动作动力学连接了之前的动作信息。

3)状态转移矩阵:跟踪器在当前状态处采取决策动作后,通过状态转移获得下一个状态,同时根据相应的动作移动边界框。

4)奖励:奖励反映跟踪器是否成功跟踪到目标。IoU表示跟踪的边界框与真实值的重叠率。当选择停止动作时,我们将奖励函数定义为

所提出的AD-OHNet网络架构如图 2 所示。

图2 网络架构

利用随机梯度下降法最小化损失函数,对网络参数进行训练。损失函数定义为

当置信度小于0.5时,则判定跟踪失败,跟踪算法进行遮挡处理。采用时空背景、物体外观模型和运动矢量驱动强化学习的动作。首先,通过对完全遮挡之前的动作和状态的统计,为当前帧提供时间和空间信息。需计算物体在每一帧中的平均移动方向和距离。其次,在物体边界框周围IoU >0.7区域随机选取k个样本作为正样本,同时在IoU < 0.3区域随机选取k个样本作为负样本。在完全遮挡的情况下,正样本和负样本保持不变。另外,需要保存之前的动作动力学矢量,以便在完全遮挡下进行目标跟踪。通过存储之前的运动矢量,跟踪器可以在后续帧中做出正确的动作,而不是在遮挡下盲目地进行搜索。根据目标的原始运动轨迹,包括运动方向和速度,保存之前的动作,使跟踪在完全遮挡情况下沿原始方向进行。利用上下文信息,获得当前帧目标的运动方向。

No.3

实验分析

我们采用中国第一颗商用遥感卫星吉林一号卫星的波哥大、香港和圣地亚哥的遥感视频序列。波哥大、香港和圣地亚哥的分辨率分别为0.92米、0.98米和1.16米。在这些视频序列中有不同的目标类型,包括飞机、汽车、船、机场、港口和军舰。波哥大、香港和圣地亚哥的原始视频的对地实际尺寸分别为55.2平方公里、58.8平方公里和69.6平方公里。每秒10帧,视频时长为33秒,每帧图像大小为12000 × 5000像素。由于原始图像尺寸过大无法提取特征,因此在视频中找到感兴趣的区域,并手动标注ground truth信息来实现目标跟踪。此外,还有一些具有挑战性的情况,如曲线行驶的目标、小目标、转弯时完全遮挡、同一视频序列中出现两次完全遮挡,以及目标被云遮挡。每个测试的视频序列有100 ~ 330帧,其中被遮挡的帧数为10 ~ 33帧不等。采用该遥感视频序列,实验验证了所提出的AD-OHNet跟踪算法的有效性。

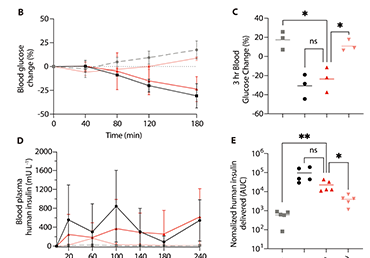

我们将所提出的AD-OHNet方法与九个先进的跟踪算法进行了比较。图3所示为precision plots 和 success plots。对比结果表明,所提出的AD-OHNet与现有的跟踪算法相比实现了卓越的性能。在遇到完全遮挡的视频序列后,大多数跟踪器将无法准确定位目标。而在AD-OHNet跟踪算法中,当阈值为20px时,精度可达92.6%。从图3可以看出,AD-OHNet方法可以有效地解决遥感视频序列的遮挡问题。

图3 precision plots 和 success plots

图4是AD-OHNet与其他五种跟踪算法进行定性比较的实验结果。其中包含了一些具有挑战性的情况,如曲线行驶的目标,小目标,甚至目标在转弯过程中被完全遮挡。

图4 实验结果

我们评估了AD-OHNet对初始化的鲁棒性。除了OPE之外,还有两种鲁棒性度量初始化评估方法:空间鲁棒性评估(SRE)和时间鲁棒性评估(TRE)。SRE通过对起始帧的目标位置信息进行移动或缩放,形成若干段测试序列进行测试和评估。TRE是从整个序列中截取若干段,即从不同时刻作为起始帧,从而实现目标跟踪。图3结果表明,该方法具有较好的鲁棒性。

No.4

总结与展望

在本文中,我们提出了一种基于深度强化学习的目标跟踪方法来解决遥感视频中目标完全遮挡的问题。该算法即使在一些稍复杂的情况下也能实现良好的跟踪性能。本文采用时空上下文、物体外观模型和运动矢量驱动遮挡下的强化学习动作。实验结果证明了该跟踪算法的有效性。然而,本研究仍不能解决某些复杂场景中的目标遮挡问题。例如,由于跟踪镜头或云的移动而导致物体被遮挡。在这种情况下,卫星和目标同时运动,目标的运动方向和速度会在遮挡过程中发生变化。未来可采用更复杂的网络模型以实现该场景下的目标跟踪。

Share Http URL: http://www.wittx.cn/get_news_message.do?new_id=917

Best Last Month

Information industry by wittx

Information industry by wittx

Information industry by wittxPain-free oral delivery of biologic drugs using intestinal peristalsis–actuated microneedle robots

Information industry by show

Information industry by wittx

Information industry by wittx

Information industry by wittxArtificial Intelligence in Chemistry: Current Trends and Future Directions

Information industry by wittx

Information industry by wittx

Information industry by wittx